AI-তে নৈতিকতা শেখানো সম্ভব কি?

বিশ্বজুড়ে বিজ্ঞানীদের বিতর্কের কেন্দ্রবিন্দুতে কৃত্রিম বুদ্ধিমত্তার বিবেকবোধ

- Author,

- Role, জাগরণ নিউজ বাংলা

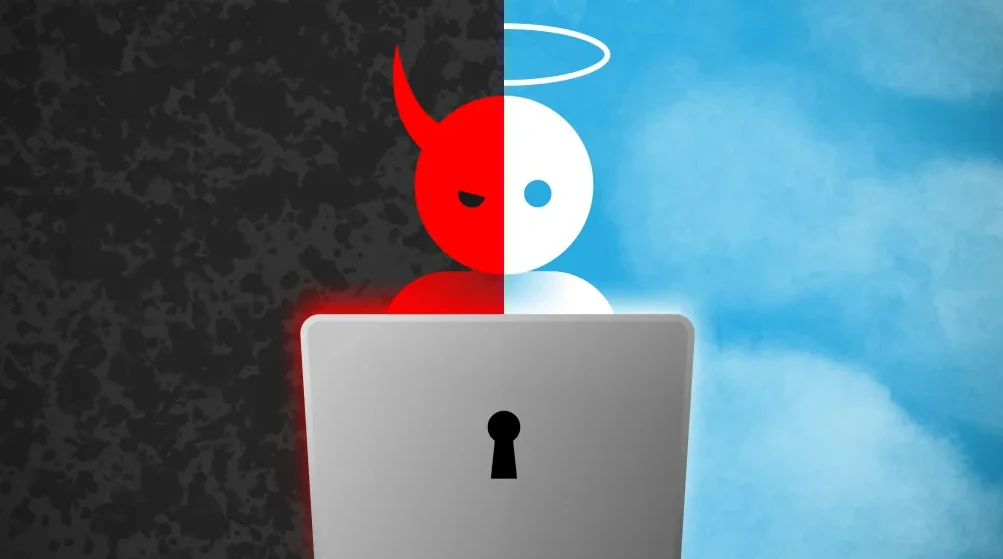

কৃত্রিম বুদ্ধিমত্তা বা AI এখন এমন এক প্রযুক্তি, যা শুধু তথ্য বিশ্লেষণ বা কাজ সম্পাদনের সীমা ছাড়িয়ে গেছে; এটি মানুষের সিদ্ধান্ত, ভাষা, এমনকি আবেগও অনুকরণ করতে পারে। কিন্তু যত দ্রুত এই প্রযুক্তি উন্নত হচ্ছে, ততই বাড়ছে এক মৌলিক প্রশ্ন যন্ত্র কি নৈতিক হতে পারে? অর্থাৎ, আমরা কি এমন এক কৃত্রিম বুদ্ধিমত্তা তৈরি করতে পারব, যে শুধু বুদ্ধিমান নয়, বরং নৈতিকও? বিশ্বজুড়ে এখন বিজ্ঞানী, দার্শনিক, নীতিনির্ধারক ও প্রযুক্তিবিদদের মধ্যে এই প্রশ্ন ঘিরে চলছে তীব্র বিতর্ক। কেউ বলছেন, "নৈতিক AI সম্ভব", আবার কেউ মনে করেন, "নৈতিকতা মানুষের, যন্ত্রের নয়।"

মানুষের নৈতিকতার উৎস মূলত অভিজ্ঞতা, আবেগ, সামাজিক শিক্ষা এবং মূল্যবোধ। একজন মানুষ ভুল থেকে শেখে, সহানুভূতি অনুভব করে, অনুতাপ জানে- এই মানসিক প্রক্রিয়াগুলো থেকেই নৈতিক সিদ্ধান্তের জন্ম হয়। কিন্তু AI শেখে ডেটা থেকে, আবেগ বা সহানুভূতি থেকে নয়। এ কারণে একটি প্রশ্ন গুরুত্বপূর্ণ হয়ে দাঁড়িয়েছে-"নৈতিকতা কি অ্যালগরিদমে রূপান্তর করা যায়?"

বিজ্ঞানীরা বলছেন, তাত্ত্বিকভাবে সম্ভব হলেও, বাস্তবে এটি অত্যন্ত জটিল। কারণ ডেটা সবসময় নিরপেক্ষ নয়; এতে লুকিয়ে থাকে মানুষের পক্ষপাত, ভুল, এমনকি বৈষম্যও।

২০১৮ সালে একাধিক গবেষণায় দেখা গেছে, কিছু স্বয়ংক্রিয় নিয়োগব্যবস্থায় (AI hiring tools) পুরুষ প্রার্থীদের অগ্রাধিকার দেওয়া হয়, কারণ প্রশিক্ষণের ডেটায় অতীতে পুরুষ কর্মীর সংখ্যা বেশি ছিল। অন্যদিকে, অপরাধ পূর্বাভাস অ্যালগরিদমে দেখা গেছে জাতিগত পক্ষপাত রয়েছে, যেখানে কৃষ্ণাঙ্গ বা সংখ্যালঘু জনগোষ্ঠীকে বেশি ঝুঁকিপূর্ণ হিসেবে দেখানো হয়। অর্থাৎ, যন্ত্র নিজে থেকে অন্যায় করে না, কিন্তু সে মানুষের অন্যায় আচরণকেই "ন্যায়" বলে ধরে নেয়। এই জায়গাতেই AI–এর নৈতিকতার সীমা সবচেয়ে বেশি স্পষ্ট।

এখন বিশ্বজুড়ে AI নৈতিকতার গবেষণাকে বলা হয় Machine Morality বা Ethical AI। এই শাখায় গবেষকরা চেষ্টা করছেন, কীভাবে AI–কে এমনভাবে প্রোগ্রাম করা যায় যাতে সে সিদ্ধান্ত নেওয়ার সময় মানবিক নীতি ও নৈতিকতার মূলনীতি অনুসরণ করে। তিনটি প্রধান পদ্ধতি ব্যবহৃত হচ্ছে -

☞ Rule-based ethics: যন্ত্রকে নির্দিষ্ট নীতি শেখানো, যেমন - "মানুষকে কোনো ক্ষতি করা যাবে না।"এটি আইজ্যাক আসিমভের বিখ্যাত Three Laws of Robotics-এর মতো।

☞ Outcome-based ethics: ফলাফলভিত্তিক নীতি- যেখানে AI–কে শেখানো হয় কোন সিদ্ধান্তটি সর্বাধিক কল্যাণ বয়ে আনবে।

☞ Learning-based ethics: উদাহরণের মাধ্যমে শেখানো, যেখানে AI মানবীয় নৈতিক সিদ্ধান্তের বিশাল ডেটাসেট থেকে 'শেখে' কোনটা ভালো বা খারাপ তা অনুমান করে।

তবে এই তিন ক্ষেত্রেই সমস্যা একই- সিদ্ধান্ত নেয় ডেটার ভিত্তিতে, অনুভূতির নয়। আর নৈতিকতা আবেগের সঙ্গেই গভীরভাবে যুক্ত।

দার্শনিকরা বলছেন, নৈতিকতা এক প্রকার "অভ্যন্তরীণ বিবেকবোধ" (moral consciousness), যা শুধু জ্ঞান নয়, অভিজ্ঞতা ও আবেগের সম্মিলন।

একজন মানুষ যদি কষ্ট দেখেও সহানুভূতি অনুভব না করে, তাহলে সে নৈতিক নয়, যদিও সে সব নিয়ম জানে। AI–এর আছে যুক্তি, কিন্তু অনুভূতি নেই।সে জানে কোন সিদ্ধান্ত বেশি কার্যকর, কিন্তু "ন্যায্য" কী, সেটি বুঝতে পারে না। এই কারণেই অনেক দার্শনিকের মতে,"AI নৈতিক আচরণ অনুকরণ করতে পারে, কিন্তু সত্যিকার অর্থে নৈতিক হতে পারে না।"

বেশিরভাগ প্রযুক্তিবিদই মনে করেন, AI–কে অন্তত সীমিত নৈতিক কাঠামোর মধ্যে রাখা সম্ভব।যেমন:

AI যেন মানুষের জীবন বা গোপনীয়তার ক্ষতি না করে। তার সিদ্ধান্তের কারণ ব্যাখ্যা করা যায় (transparency)।অ্যালগরিদমিক জবাবদিহিতা বজায় থাকে (accountability)।

ইউরোপীয় ইউনিয়নের "Ethical Guidelines for Trustworthy AI" এই তিন নীতিকেই বাধ্যতামূলক করেছে। এছাড়া UNESCO, OECD, এবং IEEE–ও এখন "AI Ethics by Design" নীতির ওপর কাজ করছে, যেখানে নৈতিকতা সফটওয়্যারের অভ্যন্তরীণ কাঠামোতেই যুক্ত করা হয়।

একটি মৌলিক সমস্যা হলো, নৈতিকতা সর্বজনীন নয়।

যে সিদ্ধান্ত এক সংস্কৃতিতে ন্যায্য, অন্য সংস্কৃতিতে তা অনৈতিকও হতে পারে।

উদাহরণস্বরূপ, গোপনীয়তা (privacy) ইউরোপে অত্যন্ত গুরুত্বপূর্ণ, কিন্তু কিছু এশীয় সংস্কৃতিতে পারিবারিক বা সামাজিক স্বচ্ছতা বেশি মূল্যবান।

তাহলে প্রশ্ন আসে, AI কোন সমাজের নৈতিক মানদণ্ড অনুসরণ করবে? মানবিক বৈচিত্র্যের এই পার্থক্যই AI নৈতিকতার সর্ববৃহৎ বাধা।

AI–এর নৈতিকতার সবচেয়ে আলোচিত উদাহরণ হলো "Trolley Problem" বা স্বয়ংচালিত গাড়ির দ্বিধা। যদি গাড়ি হঠাৎ দেখে একদিকে একজন পথচারী, আর অন্যদিকে পাঁচজন, তখন কোনদিকে ঘুরবে?একজনকে বাঁচাতে পাঁচজনের প্রাণ নেওয়া কি নৈতিক? এই প্রশ্নের উত্তর নির্ভর করে মূল্যবোধ, দৃষ্টিভঙ্গি ও সংস্কৃতির ওপর, যা যন্ত্রের জন্য নির্ধারণ করা প্রায় অসম্ভব।

কিছু গবেষক এখন "Artificial Consciousness" বা কৃত্রিম চেতনা নিয়ে কাজ করছেন।তাদের ধারণা যদি ভবিষ্যতে AI–এর মধ্যে নিজস্ব উপলব্ধি (self-awareness) তৈরি করা যায়, তবে সে হয়তো সিদ্ধান্ত নেওয়ার সময় আবেগ ও নৈতিকতা একসাথে বিবেচনা করতে পারবে। তবে এই পর্যায়ে পৌঁছানো এখনো দূরের স্বপ্ন, আর সেই স্বপ্নের সঙ্গে জড়িয়ে আছে নতুন নৈতিক ও অস্তিত্বগত প্রশ্নও।

নৈতিক AI–এর ধারণা আমাদের সভ্যতার এক বড় পরীক্ষা।

কারণ, এটি প্রযুক্তির সীমা নয়, বরং মানবতার সীমাও যাচাই করছে।

AI–কে নৈতিক করা মানে কেবল তাকে নিয়ম শেখানো নয়; বরং তাকে এমনভাবে তৈরি করা যাতে সে "মানুষের কল্যাণকে" প্রাধান্য দেয়-ডেটা নয়, মূল্যবোধকে কেন্দ্র করে চিন্তা করে। কিন্তু আজকের বাস্তবতা বলছে, AI এখনো মানুষের প্রতিচ্ছবি, তার বিকল্প নয়।যতদিন না সে নিজের সিদ্ধান্তের ফলাফল অনুভব করতে পারবে, ততদিন পর্যন্ত নৈতিকতার আসল রূপ থাকবে মানুষের হাতেই।

আপনার প্রতিক্রিয়া জানান

মন্তব্যসমূহ

এই সংবাদের জন্য এখনো কোনো মন্তব্য নেই।